Effets d'annonce

10 mai 2012

Depuis que j'ai commencé à mettre mon nez dans l'affaire ITER et dans les tokamaks, se multiplient les effets d'annonce. Le mot "disruption" est apparu dans Wikipedia. Lors des visites, à Cadarache, le public ne se contente plus d'admirer la belle maquette qu'on leur présente et d'écouter sans mot dire les parole d'une charmante hôtesse. Les gens commencent à poser des questions.

Ces jours-ci un nouveau papier militant à l'appui du projet ITER est apparu dans les sites. J'ai été inondé de messages à ce sujet, et j'ai décidé de répondre dans mon site. Une fois de plus, c'est du pipeau complet. Ca a été mon impression, confirmé par des coups de fils donnés aux spécialistes des plasmas chauds qui sont obligés de se taire, étant encore en poste.

Dans une dizaine de jours je vais donner une conférence dans la région, sur ITER et le nucléaire en général, si j'ai le temps de le faire. Il y a une longue vidéo ( une heure cinquante ) sur le site d'Enquête et Débat, que je vous conseille de regarder, où je me faisais l'écho des critiques lancées en septembre 2011 par Glenn Wurden ( que j'ai eu une heure au téléphone il y a quelques mois), formulée lors d'un colloque sur les futurs tokamaks en septembre 2011 à Princeton. Dans la vidéo je détaille ses "slides", présentés en anglais, puis immédiatement en français. C'est dans "best off" du site Enquête et Débat (case en haut et à droite, verte ).

Mais une heure cinquante, c'est long. Il aurait fallu fragmenter cela en séquences. A l'époque j'avais tout enregistré d'une traite, sans montage. Il aurait été bien qu'il y ait un lien permanent sur le site de Sortir du Nucléaire, qui ne fait que de l'événementiel. J'avais suggéré à Philippe Brousse, président de ce collectif regroupant 900 associations, de mettre une icône sur la page d'accueil, envoyant vers des articles de fond, sur les aspects scientifiques et techniques du nucléaire. Il ne m'a jamais répondu. Ce sont des organisateurs de happenings.

La conférence que je vais donner sera enregistrée en vidéo et aussitôt diffusée sur le net. Ceux qui font cette prise d'image et de son se chargeront de l'insertion d'images que je leur fournirai. C'est cela qui prend un peu de temps. Il faut aussi caler ces images exactement au bon moment et pendant une durée adaptée.

Je prépare aujourd'hui une collection de maquettes, basées sur des petits tores en polystyrène, de 30 cm de diamètre, que j'ai achetés hier à Aix. Je tenterai une première : essayer d'expliquer les principes du fonctionnement d'un tokamak, donc d'ITER, ce que les gens ignorent totalement. Il faut dire que le choix de l'expression "champ magnétique poloïdal" n'était pas de nature à rendre ces choses claires.

Je vais essayer de caler tout ce que je pourrai dans 45 minutes, le temps maximal d'attention que des spectateurs peuvent accorder.

Les organisateurs ont essayé de donner à cette manifestation un allure de débat. Michel Claessens, responsable de la communication à ITER, avait d'abord accepté. Puis, sachant qu'il serait face à moi, il s'est récusé, disant qu'il ne voulait pas débattre avec quelqu'un de "trop négatif" (...).

Même dérobade chez les scientifiques de 'Institut de Recherche sur la Fusion Magnétique, sis à Cadarache, intra muros, bastion de la fusion en France. Michel Chatelier, Gabriel Marbach, anciens directeurs. Alain Bécoulet, spécialiste d'Iter, Philippe Gendrih, directeur de recherche dans cet institut, "monsieur Fusion au CNRS".

On mettra des chaises vides avec leurs noms et on filmera.

Tout cela est fatigant et je suis fatigué. 75 ans, ça pèse un peu quand même.

Bon, venons-en à ces effets d'annonce. Il faudra les reprendre les uns après les autres par le menu et récuser tout cela dans cette page.

Iter Organization a des moyens, de l'argent, de quoi impulser une diffusion d'informations, face à laquelle le public et les internautes étaient jusque là sans recours. Là, il s'agit d'un communiqué récent concernant "la limite de Greenwald". Je reproduis d'abord le communiqué, puis j'explique :

Source :

Sciences physiques et nanotechnologies Un pas de plus vers la maîtrise de la fusion nucléaire ?

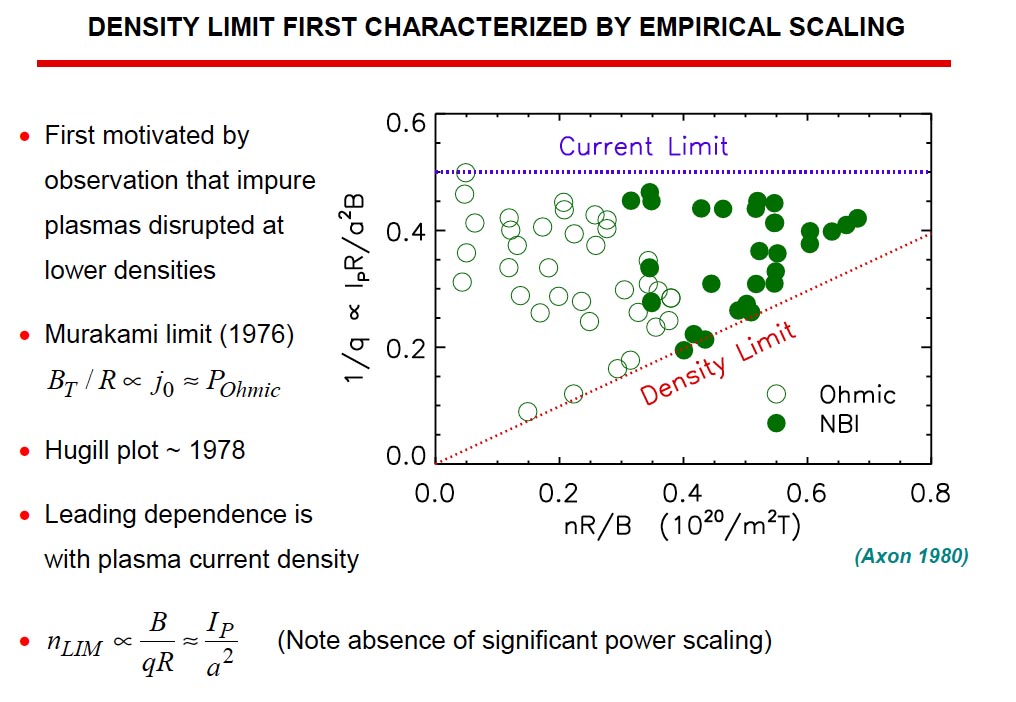

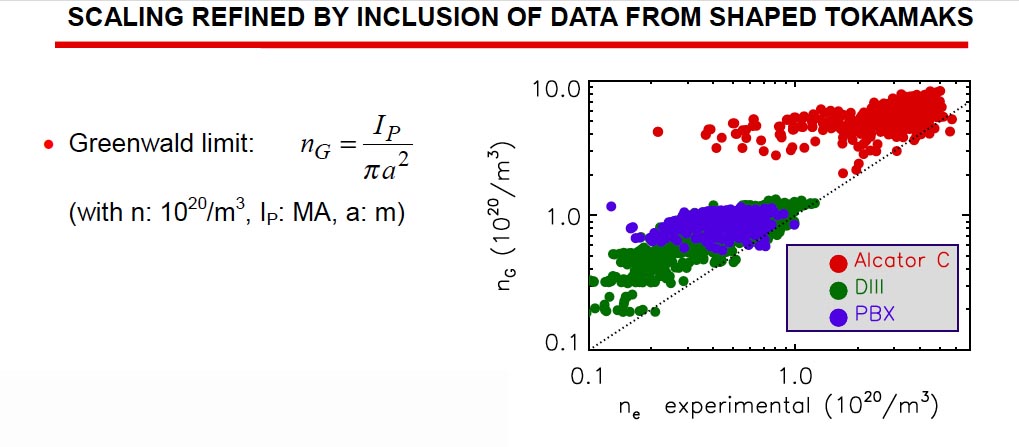

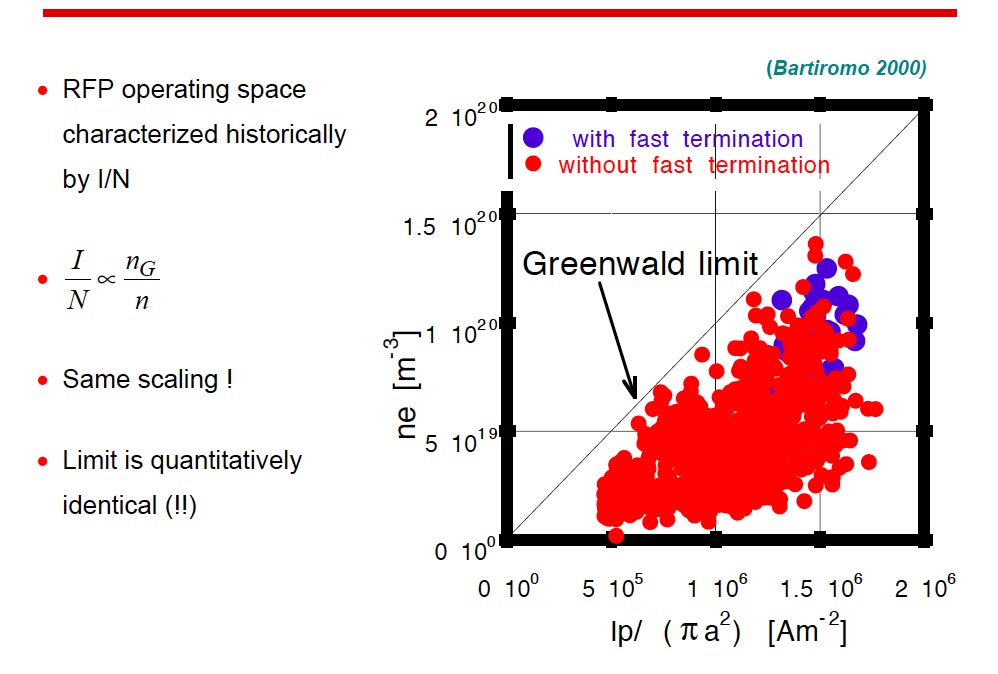

En effet, à l'heure où l'avenir énergétique de la planète est au coeur des préoccupations, la fusion nucléaire constituerait une source d'énergie idéale car abondante et peu polluante. Cependant, les conditions strictes permettant la fusion sont difficiles à mettre en oeuvre si bien que la technologie en est encore au stade de la recherche et de l'expérimentation aujourd'hui. L'objectif de réaliser une centrale à fusion, qui convertirait la chaleur dégagée par les réactions de fusion en électricité, est encore loin d'être atteint. Les communautés scientifiques nationales et internationales se sont lancées dans de gros projets à la hauteur de cet enjeu considérable. L'ampleur des investissements laisse perplexe une partie de la population. Le développement de la fusion nucléaire est actuellement une source de débats quant à la pertinence d'engager de telles sommes pour un résultat non assuré. Dans ce contexte, les attentes sont nombreuses et pressantes. C'est donc avec enthousiasme que Luis Delgado-Aparicio et David Gates, tous deux physiciens au Princeton Plasma Physics Laboratory du U.S. Department of Energy, ont récemment fait part de leur découverte. Ils se sont intéressés aux instabilités qui peuvent survenir au sein du plasma dans les configurations de type "tokamaks", et qui constituent le problème majeur freinant leur développement. L'apparition de ces instabilités tridimensionnelles dites "disruptions" ont été reconnues comme inévitables, même en conditions normales de confinement. Elles correspondent à une perte violente et très rapide du confinement du plasma, et peuvent endommager significativement le matériel. Par ailleurs, les risques d'endommagement sont d'autant plus élevés que la puissance du tokamak est importante. Ainsi le prototype de tokamak de puissance ITER, actuellement en cours de construction à Cadarache, pourrait voir l'ensemble de son installation gravement endommagée. L'une des causes importantes de ces disruptions est l'élévation de la densité du plasma au-delà d'une certaine valeur critique dite "limite de Greenwald". Cette limite semble universelle et son origine reste jusqu'à ce jour énigmatique. Pour que la fusion se produise dans le plasma, il faut que celui-ci soit suffisamment dense et chaud pour permettre le rapprochement des noyaux légers contenus dans ce plasma et provoquer leur recombinaison en noyaux plus lourds. Cette recombinaison s'accompagne d'un fort dégagement d'énergie sous forme de chaleur, que l'on cherche à récupérer pour produire ensuite de l'électricité. Cette réaction de fusion est d'ailleurs mise à l'oeuvre naturellement dans le soleil et la plupart des étoiles. A priori, plus on injecte d'énergie dans le plasma, plus l'on s'attend à en augmenter la densité, et donc à privilégier les réactions de fusion. La limite de Greenwald contredit cette intuition. Par ailleurs, étant donné que le taux de réactions nucléaires est proportionnel au carré de la densité du plasma, cette limite bride les performances d'un tokamak de taille donnée. Ainsi les scientifiques cherchent à en expliquer les origines depuis des décennies. L'étude approfondie de L.Delgado et D. Gates se penche sur ce problème. Ils proposent une explication toute fraîche, différente de celle proposée par Greenwald, le physicien du MIT qui a établi l'équation décrivant cette limite (et qui porte son nom) Ma remarque : Greenwald n'a pas établi son équation sur des bases théoriques. C'est ce que le CEA appelait, dans le texte mis en ligne sur son site, destiné à me déconsidérer (et pour lequel je n'ai pu bénéficier de droit de réponse) : une "loi ingénieur", c'est à dire une formule totalement empirique, déduite des observations. Vous trouverez cette belle formule en composant Greenwald limit dans Wikipedia :

On voit que selon cette loi, il est impossible de dépasser, dans un tokamak, cette valeur de la densité, proportionnelle au "courant plasma", au courant qui se boucle dans le plasma (un million et demi d'ampères dans Tore Supra, 15 dans ITER) et inversement proportionnelle au carré de la valeur du "petit rayon" de la chambre toroïdale. Ces études ont été initiées par Greenwald dans les années quatre vingt de manière totalement empirque. Un article de lui, datant de 1988

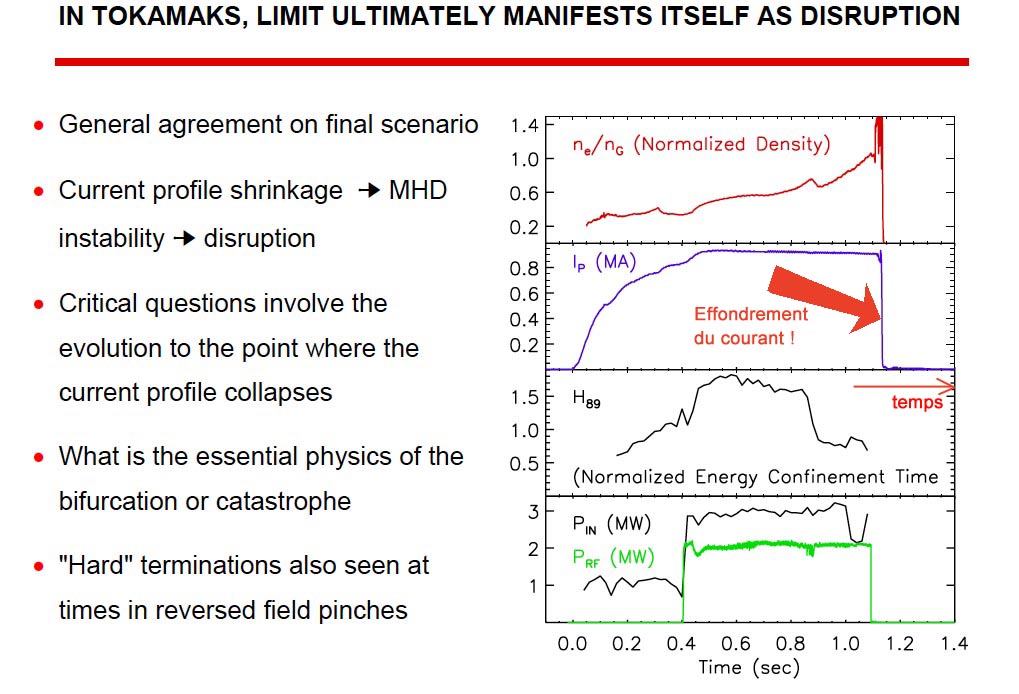

Revenons à l'annonce faisant l'objet de cet encadré : D'après Greenwald, l'instabilité proviendrait d'un rayonnement excessif du plasma de bord qui abaisse sa température, augmentant ainsi sa résistivité. Le courant qui circule dans le plasma se transfère alors du bord vers son centre, si bien que la densité de courant au centre atteint la valeur seuil (dite de Kruskal-Shafranov (KS), proportionnelle au champ toroïdal) à partir de laquelle se développe une instabilité magnétohydrodynamique (MHD) : le plasma s'entortille et touche la paroi du tokamak où il se refroidit. Le courant du plasma est ainsi forcé de pénétrer dans la paroi, d'où des dégradations. Cependant l'initiation et le terme de ce processus ne sont pas clairs. L'approche proposée par L. Delgado et D. Gates se concentre sur les îlots magnétiques qui se forment lorsque la limite est atteinte. Ils montrent à l'appui d'équations que ces derniers seraient la cause de l'effondrement du plasma. Le rapprochement entre ces ilots et l'effondrement n'est pas nouveau, mais la relation de cause à effet n'a pas été mise en évidence dans les précédentes études. Voilà donc le nouveau scénario qu'ils proposent : les îlots seraient responsables de deux effets négatifs : d'une part ils accumulent des impuretés provenant des parois du tokamak qui refroidissent le plasma, et d'autre part, ils agissent tels des boucliers contre l'ajout supplémentaire d'énergie dans le système. Lorsque la puissance injectée devient inférieure à la puissance dégagée des îlots par effet Joule, l'équilibre se rompt. Les îlots se développent jusqu'à atteindre une taille suffisamment importante pour entraîner l'effondrement du courant électrique qui aide à confiner le plasma. Le plasma disparaît alors en quelques millisecondes. Il ne reste maintenant plus qu'à vérifier ces hypothèses expérimentalement, ce qui est prévu prochainement sur les tokamaks C-Mod du MIT et DIII-D de General Atomics à San Diego. Grâce à cette nouvelle vision du problème, L. Delgado et D. Gates ont pensé à une éventuelle solution pour parvenir à des densités au-delà de la limite de Greenwald : celle-ci consisterait à injecter l'énergie directement au coeur des îlots. Si cette manipulation s'avérait fonctionner, les conditions nécessaires à la fusion (hautes températures et densité élevée) pourraient alors être bien plus aisément mises en oeuvre dans le futur. " Si... " comme disaient les Lacédémoniens

|

Ce qui suite est extrait d'un article plus récent ( une communication de 2001 )

Si on lit le papier de Greenwald, on verra à quel point ça ne s'appuie sur aucun bagage théorique conséquence. C'est de l'empirisme pur. Il a eu l'idée de cette loi, au pif, et il l'a testée. Et les courbes qu'ils donnent semble cadrer avec ce qu'il avait imaginé. Mais il n'y a aucune relation de cause à effet évidente. Cela montre la faiblesse de la la façon dont les théoriciens ont prise sur ce problème des plasmas chauds soumis à des champs magnétiques.

Greenwald est un expérimentateur, qui a fait sa thèse sur la machine ALCATOR, aux USA, dans les années quatre vingt. Il a augmenté progressivement la densité dans la chambre en y injectant des glaçons d'hydrogène solidifié. Ca créait des accroissements de densité localisés, mais qui se diffusaient rapidement dans toute la chambre. Il a mis en évidence une valeur limite de densité, qu'il s'est attacher à situer, avec des valeurs de courant plasma différentes, paramètre sur lequel il pouvait jouer. C'est là qu'il a vu que la densité critique dépendait du carré de l'intensité de ce courant, assez fidèlement. Mais ce fut un simple constat d'expérimentateur.

Par la suite il a raffiné son travail, et ce qui suit est extrait d'une communication de 2001

Un des graphiques sur lesquels Greenwald a porté des cas de disruptions.

A propos des disruptions, il donne dans son papier une courbe qui montre la brutalité de l'effondrement du courant :

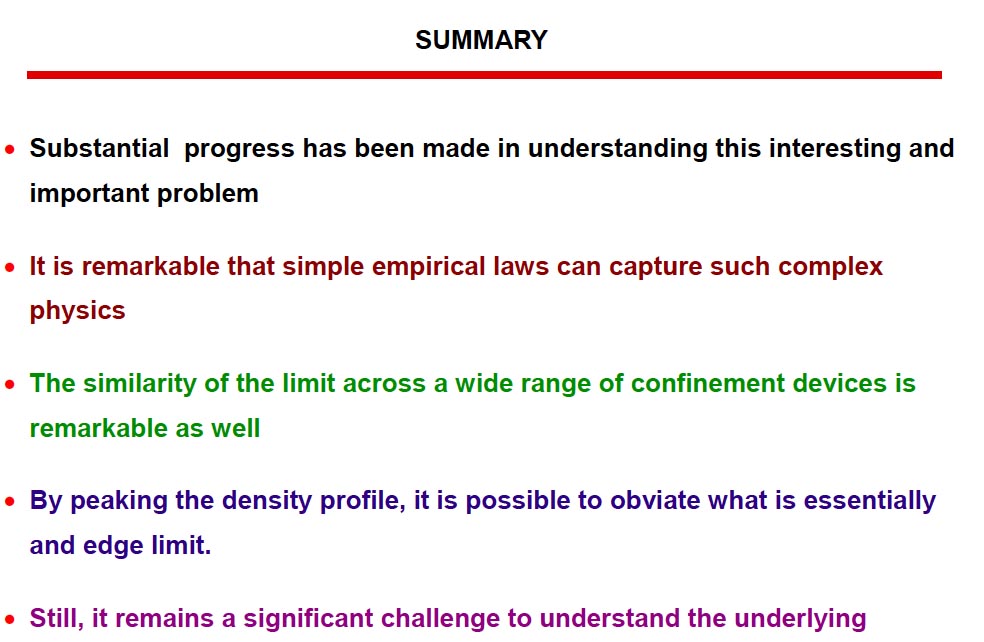

Voici la conclusion que donne Greenwald :

- Ceci représente un progrès substantiel pour comprendre ce problème à la fois important et intéressant (...)

- Il est remarquable qu'une simple loi empirique permette d'avoir prise sur un problème aussi complexe.

- Le fait que cette loi puisse s'appliquer aussi bien à une large gamme de systèmes de confinement est remarquable.

- ........

- Mais comprendre ce qui est à l'origine de ce phénomène reste un défi.

On a commencé à expérimenter sur les tokamaks dès les années cinquante, cela signifie qu'on a fonctionné pendant des décennies en étant confronté à un phénomène brutal, destructeur, auquel on ne comprenait STRICTEMENT RIEN. Je me souviens du coup de fil d'une heure que j'avais eu avec Philippe Gendrih, directeur de recherche à l'IRFM, qui avait décrit cette limite de Greenwald comme "un élément important".

Il s'agit donc de la maîtrise empirique d'un phénomène, concrétisée il y a un quart de siècle par une "loi ingénieur", dont la compréhension n'a pas depuis progressé d'un iota.

A noter que Gendrih refuse mordicus tout face à face avec moi, filmé (et donc diffusé sur le net).

Cette "loi ingénieur" pondue par Greenwald, comme dirait l'imbécile qui a pondu ces dix pages sur moi dans le site du CEA, est un échantillon de tout ce dont on dispose pour piloter un tokamak, une machine aussi problématique qu'ITER. Vous avez pu lire que Greenwald pensait que les disruptions provenaient d'un phénomène qui prenait naissance près des parois, puis se propageait vers le coeur du plasma.

Qu'on pilote une manip de taille modeste avec des "lois ingénieur", passe encore. Mais c'est irresponsable d'asseoir sur de tels outils de pilotage "la plus grande expérience de physique jamais montée in the World".

Le papier évoqué dans cette page, de L.Delgado et D. Gates, a été salué comme "une grande découverte" dans la revue "l'Usine Nouvelle". Delgado et Gates suggèrent que les disruptions trouvent leur origine au coeur du plasma, et non à travers des instabilités de bord qui créent un refroidissement, qui se propagerait à coeur (comme le fait Greenwald). Ils font allusion à ces "îlots" qui ont tendance à se former dans le plasma et qui sont des formes de turbulences magnétiques à grande échelle. En fait, l'avancée faite par ces chercheurs représente l'intérêt porté par des termes, dans une équation.

Le plasma des tokamaks se pollue inévitablement, par arrachement d'atomes, de poussières microscopiques à la paroi. Ces atomes, ou agrégats d'atomes ont des numéros atomiques importants (comme par exemple le tungstène qui, ionisé, peut porter des dizaines de charges électriques). Or les ions sont la cause d'un accroissement des pertes radiatives, par rayonnement de freinage. Celui-ci croît comme le carré de la charge ionique. Donc pollution par des ions arrachés à la paroi = refroidissement radiatif du plasma. En dessous d'une certaine température, ce plasma redevient résistif.

Avant qu'une disruption ne survienne, la résistivité du plasma est infime. Dans ITER on créera un courant de 15 millions d'ampères, à l'aide d'un champ induit (par la lente croissance d'un champ magnétique créé par le solénoïde situé près de l'axe de la machine, disposé verticalement), champ induit qui est inférieur au volt par mètre. Ainsi la résistance du plasma est de l'ordre de quelques millionièmes d'Ohm. Pour deux raisons. Primo le plasma est peu dense (la pression de remplissage correspond à un centième de mm de mercure). Secundo les électrons, en circulant à grande vitesse, voient leur probabilité d'interagir avec les ions s'effondrer. Or l'effet Joule est précisément issu des collisions entre électrons et ions.

Un autre phénomène, absolument pas maîtrisé au plan théorique, doit intervenir. Ces poussières, réparties dans tout le volume du plasma, sont susceptibles de donner naissance à des micro-turbulences. Que sait-on à ce sujet ? Pas grand chose. La raison est simple : on est totalement incapable de simuler numériquement l'action de ces poussières.

Les micro-instabilités appartiennent au monde des plasmas hors d'équilibre et s'ébattent donc, non dans un espace à trois dimensions, mais dans un espace à six (trois pour la position, trois pour la vitesse). On sait que ces micro-instabilités peuvent naître dans les plasmas de fusion. Ce sont elles qui permettent d'atteindre des températures de plusieurs milliards de degrés dans les Z-machines, phénomène découvert en 2005 par Malcom Haines. Dans ces cordons de plasma hyper denses, elles accroissent les probabilités de collision entre les électrons qui déboulent à très grandes vitesses (et qui représentent un courant se chiffrant en dizaines de millions d'ampères), et ces paquets d'ions, porteurs de nombreuses charges. D'où une "résistance anormale", que personne, maintenant, ne conteste plus, après une intense désinformation américaine de 2006 à 2010.

Comme je l'ai écrit, le bonheur des uns peut devenir le malheur des autres. On ne voit pas pourquoi ni comment des micro-instabilités ne prendraient pas naissance dans les tokamaks, provoquant des disruptions.

Prenez l'exemple des planeurs. On atteint des finesses phénoménales (52) avec des états de surfaces incroyablement lisses. Ce chiffre signifie simplement qu'un tel planeur peut, dans un air immobile, franchir 52 kilomètres avec une perte d'altitude de mille mètres !

Tout cela parce qu'on retarde au maximum l'apparition de la turbulence, génératrice d'un accroissement de la traînée. Le soir, après un vol, on nettoie les ailes du planeur avec une éponge et de l'eau, et on les protège des poussières avec d'immenses "chaussettes".

Imaginez qu'une nuit, de la poussière vienne se coller sur ces ailes. Le lendemain, finies les belles performances ! Chaque poussière crée dans son sillage une turbulence.

Peut-on empêcher ces arrachements de matière à la paroi ? La réponse est catégoriquement NON.

Dans les tokamaks, cette turbulence se joue en volume. Ce qui est grave, pour le théoricien, c'est que ces poussières, qui jouent un rôle très important, détruisent tout espoir de modélisation. Quelle quantité ? Avec quelle masse ? Quelle charge électrique ? Pas de réponse à ces questions essentielles.

Le système est complètement métastable, du fait de cette gamme incroyablement vastes d'instabilités de toutes tailles, allant du mètre au micron. C'est à dire que si la résistivité du plasma remonte, la vitesse de circulation des électrons diminue, ce qui ... accroît la probabilité d'interaction avec les ions, donc accroît la résistivité. Un feed back non-linéaire extrêmement violent. D'où cet effondrement spectaculaire du courant plasma, lisible sur la courbe.

Un système métastable est un système dont l'état de régime peut se trouver soudain détruit par un phénomène qui pourrait sembler mineur, mais qui entraîne l'effrondrement de ce château de cartes.

Le champ inducteur est incapable de s'opposer à cette chute brutale. Dès que la disruption démarre, le plasma est complètement livré à lui-même, en un millième de seconde et on ne dispose pas d'instruments de mesure ayant des temps de réponse assez courts pour détecter des signes avant coureurs de cette catastrophe.

Ce que suggèrent nos deux bonshommes, c'est d'apporter de l'énergie dans ces cellules turbulentes.

Comment ? Ca n'est pas dit dans la chanson.

Il resterait encore à localiser ces fameux îlots dont parle l'article, ces macro-cellules turbulentes. Pour ce faire il faudrait pouvoir disposer, en temps réel d'une carte 3d du champ magnétique dans toute la chambre. Comment ?

Personne n'en a la moindre idée.

La conclusion de ce papier (de cette "grande avancée") pourrait s'énoncer ainsi :

- En détectant les fluctuations magnétiques que représentent les îlots, à l'aide d'une méthode à imaginer, et en y injectant alors de l'énergie, sous une forme, et d'une façon qui resterait à définir, on pourrait peut être s'opposer à la chute de température préludant à une disruption dans le plasma.

On pourrait donner une image d'une telle situation. Imaginez qu'on veuille interdire toute ascendance dans une atmosphère foncièrement instable. En haut, de l'air froid et sec. En bas, de l'air chaud et humide. Soudain quelqu'un a une idée : on pourrait contrôler cette atmopshère en y injectant de l'énergie, dans les zones froide, pour maintenir un minimum d'homogénéité thermique

Très bien, répond quelqu'un :

- Comment faites vous, à distance, pour mesurer la température de l'air, son degré hygrométrique ?

- Et si vous détectez une inhomogénéité, comment faites vous pour apporter de l'énergie dans les régions froides ?

Il y a eu d'autres communications fracassantes, dont les médias se sont faits l'écho. De simples effets d'annonce, sans fondements. En fait les responsables d'ITER sont inquiets, parce que le public commence à comprendre comment cette machine est conçue et quels sont ses défauts fonciers. Les gens posent des questions.

Mauvais ....

Ces "générateurs du III° millénaire", exploitant "l'énergie bleue, pour sauver la planète bleue" ne sont rien d'autre que ces vieux tokamaks instables, que les scientifiques ont proposé à Gorbatchev et Reagan, pour répondre à leur souci (à leur fantasme de politiciens) de lancer des recherches nucléaires qui soient exemptes de retombées militaires. En matière de fission, la frontière entre le domaine des applications civiles et celui des applications militaires est ténue. Qu'on réduise la "modération" dans un réacteur, et le voici qui devient un réacteur à neutrons rapides, plutinogène. Bien sûr, les réacteurs foncièrement plutinogènes ne sont pas conçus comme les réacteurs militaires. Mais on n'a jamais vu un pays qui démarre par du civil ne pas se retrouver x années plus tard avec des bombes dans ses placards.

Dans le fonctionnement normal d'un réacteur civil, contenant 3 % d'uranium 235 il se forme du plutonium 239. C'est d'ailleurs ce plutonium que les Français récupèrent dans l'usine "de retraitement" de la Hague. Le discours est :

- Confiez-nous vos déchets. Nous extrayons le précieux plutonium. que nous gardons pour nous. En échange nous vous rendons ces déchets, conditionnés dans des blocs de verre.

Le bon peuple continue de sourire quand des militants écolos viennent s'enchaîner aux rails de trains apportant les déchets. Les gens ne se rendent pas compte des enjeux, de ce qui se trame derrière tout cela. Eux, qui prennent des coups de matraque sur la tête, si. C'est comme ça ....

Le jour anniversaire de la catastrophe de Tchernobyl j'ai rejoint un petit groupe de militants, devant l'entrée de Cadarache. Il y avait une petite centaine de bonshommes "formant une chaîne", et j'étais le seul scientifique présent.

Eh oui, ils sont nuls, nos scientifiques. Quand il n'abondent pas dans les rêves déments de nucléopathes.

Sylvain David, du CNRS, lors des assises d'une commission parlementaire en 2011:

- Il faut conserver le précieux plutonium et non le traiter comme un déchet.

Du plutonium, pourquoi faire ? Pour grossir le stock. La France en détient 400 tonnes, réparties un peu partout, dont 60 à la Hague. Le but visé, approuvé par les députés Christian Bataille et Bruno Sido, (animateurs des sessions consacrées à l'avenir du nucléaire, où les spécialistes auditionnés étaient issus du CEA, d'EDF, d'AREVA, d'ITER et du Cnrs) est de monter en 2060 à 1000 tonnes de plutonium.

Le député pro-nucléaire à tout crin Christian Bataille

Son compère, Bruno Sido

Alors la France pourra entreprendre le "déploiement" de "réacteurs de IV° génération", qui ne sont rien d'autre que des surgénérateurs à neutrons rapides, fonctionnant au dangereux sodium, comme Superphénix, de triste mémoire.

Ce déploiement serait achevé en 2100. Les surgénérateurs recyclent l'uranium 238, issu du raffinage du minerai, par séparation isotopique, pour en faire ... du plutonium. Les Phénix est un oiseau qui ... renaît de ses cendres.

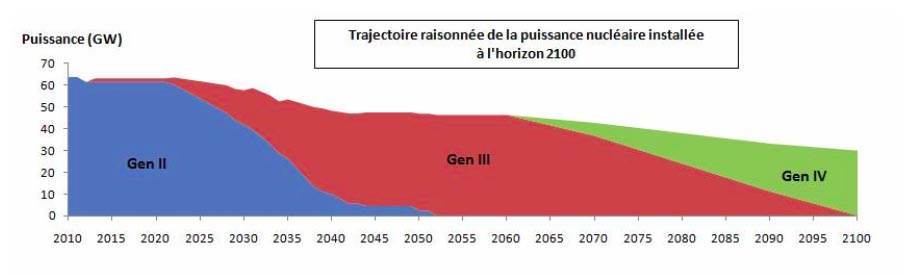

Le projet officiel de déploiement des générateurs nucléaires de génération III, puis IV

En imaginant qu'en un siècle la physique n'aura pas bougé d'un iota !

Si tout cela était sans déchets, sans danger, avec son stock de 300.000 tonnes d'uranium 238 la France pourrait couvrir ses besoins en énergie pendant ... 5000 ans !

C'est la raison pour laquelle des chercheurs du CNRS, impliqués dans cette folie, recommandent que le plutonium ne soit pas considéré comme un déchet, vitrifié, mais au contraire conservé précieusement, comme combustible du futur.

Ce plutonium, on le trouve déjà dans le MOX (mixed oxydes). 25 % du parc des réacteurs français fonctionne avec des chargement constitués avec une proportion de MOX. L'EPR est conçu pour fonctionner avec 100 % de MOX. C'est l'étape intermédiaire avant le passage aux surgénérateurs.

L'EPR avec son "récupérateur de corium" (en orange )

Malheureusement, cette filière des surgénérateurs est un techno-cauchemar. Le plutonium est hyper dangereux, car il possède une "durée de vie biologique" de 40 années. Si vous inhalez ou que vous ingérez un milligramme de plutonium, celui-ci se fixera immédiatement dans votre corps. Aucun appareil de mesure ne pourra mettre en évidence sa présence. Vous ne serez pas "irradié", mais "contaminé". Cette ou ces particules de plutonium s'attaqueront à vos cellules les plus proches, de manière totalement insidieuse. Quand vous décéderez d'un cancer, il vous sera absolument impossible de prouver que celui-ci est dû à cette contamination.

Avec mille tonnes de plutonium, faites le calcul, on pourra tuer un milliard d'être humains. Avec le stock de plutonium actuellement détenu sur Terre (une substance qui n'existe pas à l'état naturel) on pourrait tuer des hommes sur tout un ensemble de ... planètes.

Des nucléo-députés ayant dépassé la soixantaine militent pour la réalisation d'un tel programme. En 2060, quand cet ambitieux projet prendrait son essor, tous seraient décédés. Et en 2100 leurs petits enfants pourraient retirer le fruit de cet effort sur le long terme. Ces gens nous décrivent notre futur technologique dans le prochain siècle, convaincus que la physique n'aura pas bougé d'un iota entre temps. Par exemple que quelqu'un n'aura pas réussi en 10 décennies, à faire fonctionner un générateur à fusion aneutronique, ne donnant pour déchets que de l'hélium. C'est théoriquement possible.

ITER, c'est autre chose, mais c'est aussi le maillon faible de l'édifice nucléocratique, fondé sur le mythe de l'excellence, de l'avant-garde, de la sûreté, de la maîtrise, etc.

Tous les spécialistes de la fusion savent que ce projet est complètement foireux. Tout est foireux dans cette histoire, de tous les côtés. C'est "un corps sans tête". Vous ne trouverez aucune personnalité qui puisse dire "je suis le directeur et le responsable scientifique du projet" et qui puisse répondre à toute question posée.

Vous avez vu par exemple que Tore Supra détient un record de durée pour le maintien en température d'un plasma. Un simple examen de la documentation montre que ce record de 6 minutes a été obtenu non avec un courant plasma d'un million et demi d'ampère, son intensité nominale, mais avec le tiers de cette valeur. Quant à la température, elle était loin d'approcher celle de la fusion. Mais les concepteurs de Tore Supra vous diront que cette machine n'a jamais été conçue pour atteindre ces fortes températures.

Vous savez peut être que le courant plasma est créé par induction, à l'aide d'un solénoïde central, disposé selon l'axe de symétrie de la machine, dont on fait lentement croître le champ magnétique. La solution pour allonger la décharge était de se montrer plus modeste quant au courant plasma visé, donc également plus modeste quant à la température atteinte. Cocorico !

Mais cela, quelqu'un vous l'avait-il dit ?

C'est l'opacité complète du nucléaire. Les politiques rêvent. Les technocrates leur bourrent le mou. Les industriels prennent les commandes, construisent, bénéficient de contrats. Les scientifiques voyagent, palabrent, avant de partir à la retraite, discrètement.

Michèle Rivasi, fin 2011, a diffusé au sein de la commission Information Technique et Recherche du Parlement Européen, ainsi que dans la commission du budget un mien document, traduit en anglais.

Aucun ne l'a lu ....

Imaginez une nouvelle à la Raymond Devos. Au sein de ces commission, un examinateur distribue un sujet d'examen qui comporte une série de questions.

- ITER est-il un tokamak ?

- Décrivez sommairement les bases du fonctionnement d'un tokamak.

- Cette machine peut-elle fonctionner en régime permanent ?

- Qu'est-ce qu'une disruption ?

etc... etc....

Vous imaginez aisément le résultat.

Avant de boucler ce texte, j'ai envie d'évoquer une anecdote. Je vous ai dit que j'avais eu Philippe Gendrih au téléphone. Il parlait de cette "limite de Greenwald" comme de quelque chose d'important. Et lui, qu'a-t-il trouvé dans sa carrière ?

Greenwald a eu la chance de découvrir cette loi empirique, qui fait que son nom est désormais dans tous les manuels, à peu de frais, finalement.

Je vais vous citer un autre exemple du même genre. Quand j'habitais 10 rue du Félibre Gaut, à Aix-en-Provence, au premier étage, j'avais un voisin américain, qui habitait un petit deux-pièces, au rez de chaussée. Il travaillait, comme moi, à l'Observatoire de Marseille, en ce milieu des années soixante dix et s'appelait Brent Tully.

Un jour il a mis des points sur un graphique, comme ça.....

Dans les galaxies spirales, le gaz tourne. Ce gaz forme un disque assez mince, comparable à celle d'un antique microsillon. Cent mille années lumière de diamètre, trois cent d'épaisseur. Près du centre, on a une rotation qui est presque en "corps solide", où la vitesse croît proportionnellement à la distance radiale. Mais, très vite, cette vitesse devient à peu près constante, et personne ne comprend pourquoi. On a même dû inventer le concept de matière sombre pour expliquer ce profil de vitesse singulier.

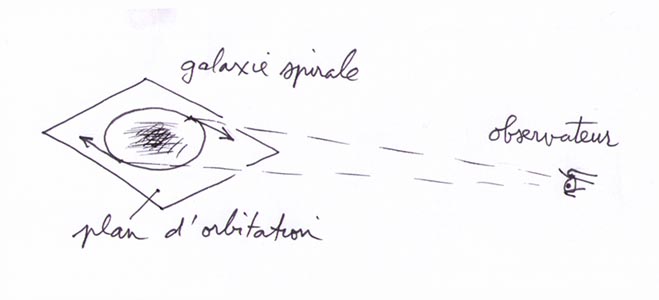

Quand on observe une galaxies spirale, elle a de grandes chances de se présenter de travers. Pour l'observateur, une portion de ce gaz ira en se rapprochant de lui, l'autre en s'éloignant.

La spectroscopie permet de mesurer ces vitesses, par déplacement des raies. On effectue les mesure avec la raie de l'hydrogène neutre, en 21 cm. Quand le gaz s'éloigne, la raie file vers "le rouge". Quand le gaz se rapproche, la raie file vers "le bleu". C'est l'effet Doppler Fizeau. Typiquement, la différence de vitesse est de l'ordre de 200 km/s.

100 km/s en rapprochement, 100 km/s en éloignement.

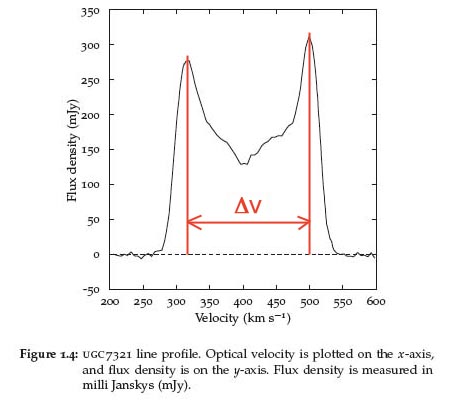

Ci-après un résultat d'observation.

Glissements des raies de l'hydrogène, dû à l'effet Doppler, pour une galaxie spirale.

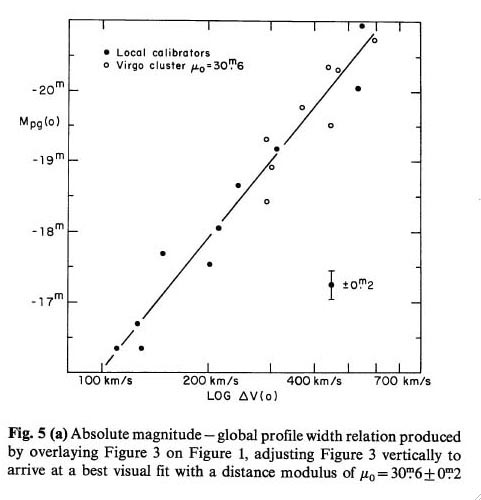

Vous savez ce qu'a fait l'ami Brent, avec un de ses copains ? Il a "plotté" cette différence de vitesses en fonction de la magnitude absolue d'un tas de galaxies spirales, cette magnitude chiffrant aussi leur masse. Et voilà ce qu'il a trouvé :

( les vitesses, en bas, sont en échelle logarithmique )

La magnitude absolue des galaxies spirales (leur masse) varie en fonction de la valeur de la racine quatrième de la vitesse de rotation en périphérie (simple remarque : la méthode n'est pas applicable aux galaxies dites elliptiques, parce qu'elles n'ont ... pas de gaz). .

Bingo !

Voilà comment on se retrouve dans tous les bouquins, dans tous les cours d'astronomie, dans toutes les langues. Ce résultat s'avéra fort utile, car il permet d'évaluer la distance de lointaines galaxies à l'aide de "chandelles de références" (comme le sont les étoiles variables, à plus courtes distances). La loi de Tully-Fisher permet d'effectuer des mesures à des distances se chiffrant en centaines de millions d'années-lumière. On mesure la "magnitude apparente", puis l'élargissement de raie. On déduit la rotation de cette seconde mesure. Puis, grâce à la loi Tully-Fisher on en déduit la magnitude absolue. La magnitude apparente étant inversement proportionnelle au carré de la distance, on en déduit celle-ci. Simple, joli, efficace.

Brent et son copain sont entrés dans l'histoire de l'astronomie.

Pourquoi est-ce ainsi ? Personne n'en a la moindre idée. C'est une "loi-ingénieur" pour astronome. D'ailleurs ni Tully, ni Fisher n'étaient des théoriciens de la dynamique galactique. Ils ne le devinrent pas non plus par la suite.

Au fait, vous en connaissez, des théoriciens de la dynamique galactique ?

Non. Il n'y en a pas. Pendant des années, Evangelina Athanassoula, à l'observatoire de Marseille, ainsi que des tas d'autres, comme Françoise Combes, devenue ... académicienne, ont simulé, à tour de bras, en vain, en manoeuvrant un puissant et coûteux ordinateur. Problème : les galaxies numériques perdent ... leurs bras, très vite. Il n'y a plus qu'une bête barre, qui tourne.

Il y a vingt ans j'avais rencontré ces deux souris, lors d'une soutenance de thèse. Athanassoula prenait des thésards à tour de bras. Dans sa puissante machine, on modifiait des paramètres, on faisait interagir ceci et cela. Et soudain quelqu'un s'écriait " mais cette image ressemble à NGC quelque chose !". Alors le thésard rédigeait. Généralement, c'étaient des étrangers, qui repartaient, thèse en poche, occuper un poste universitaire à Brasilia ou Tombouctou.

Le bilan scientifique des carrières de ces deux dames : néant. Des "contributions", des discours, parfois des livre (aujourd'hui d'élégants powerpoints). Evidemment, des tonnes de publications. Pour le baratin, Combes est imbattable. C'est André Brahic en femme.

Il y a vingt ans donc, j'ai montré à ces deux dames les résultats d'une simulation 2d, effectuée sur le puissant ordinateur allemand du centre de recherche de Daisy. J'avais amené un petit Mac portable. Mais depuis, le fichier original, propre, a été égaré.

J'avais fait tourner une masse de gaz, nichée dans une alvéole de matière à masse négative, donc répulsive. Ca redonnait la courbe de rotation. Mieux, le truc se dotait de beaux bras spiraux ("comme sur les photos", disaient mes collègues astronomes). Et ces bras perduraient des dizaines de tours.

Leur raison suffisante ? La friction de la matière à masse positive sur son environnement à masse négative. LA forme de la courbe de rotation ? Les survitesses périphériques trouvaient là leur explication.

Je n'ai jamais pu publier ce travail. Toutes les revues auxquelles j'envoyais ce travail répondaient régulièrement :

- Sorry, we don't publish speculative works.

J'en ai essayé une douzaine, puis j'ai laissé tomber.

Ma galaxies spirale.

Des années plus tard, j'ai eu l'idée, mes vieux lecteurs doivent s'en souvenir, de lancer un projet " Epistemotron". J'ai constitué, via internet, un groupe d'internautes, en général informaticiens. L'idée était d'accroître le nombre des points masses (le système ci-dessus en comportait deux fois 5000) en faisant du "calcul partagé. Avec plusieurs ordinateurs personnels on aurait pu monter à un très grand nombre de points, faire jeu égal avec les plus puissantes machines. Le projet était sympa. J'avais commencé à expliquer à cette troupe les tenants et aboutissants de la dynamique des galaxies.

Les choses progressaient. Les gars retrouvaient de belles structures spirales. J'avais même développé le travail sur une "sphère S2" pour éviter les artefacts liés aux effets de bords ( qui donnent ces quatre "cacahuètes" qu'on voir dans l'article en lien, jamais publié), dans un espace de calcul qui était l'écran de l'ordinateur, où on faisait rentrer par la gauche les points masses qui sortaient par la droite, et vice-versa. Même chose pour le "haut-bas". Quand le nombre des points aurait été suffisant, j'avais même prévu un calcul dans un espace 3d hypersphérique.

Eh puis, un jeune imbécile de Canadien réussit à faire fonctionner plusieurs ordinateurs avec succès. Il multiplia très vite le nombre des points masses. Et un jour il annonça :

- Je reprends toute cette affaire à mon compte. Je crée un site et tout passera désormais par moi. Nous ferons ce travail avec ou sans Jean-Pierre Petit.

Dallas.....

Je me suis aussitôt retiré et, une fois de plus, un nième projet s'est effondré comme un château de cartes (comme les projets MHD, au Cnes ou à Rouen).

Quand il a vu qu'il était infoutu de gérer cette affaire, le Canadien m'a fait de plates excuses. Mais j'en ai eu marre. Je me suis dit "pourquoi continuer ? Il y aura immanquablement un jour un autre type qui tentera de faire le même coup ".

Ce qui est terrible, dans le monde de la recherche, c'est la bêtise.

En fait, dans ces simulations, il suffit de faire interagir deux populations de masses opposées. Depuis mes travaux de 1990 ça n'a jamais été fait, et on peut se demander pourquoi. La raison est peut être que ceux qui utilisent les logiciels, (bourrés d'astuces pour accélérer les calculs, comme le tree code) ne sont pas ceux-là même qui les ont créés. Et il n'y a pas, dans la définition des conditions initiales, de question comme :

- Choisissez le signe des masses de cette population.

Tant que cela n'aura pas été modifié, on continuera à ramer avec des masses exclusivement positives.

Nouveautés Guide (Index) Page d'Accueil

a

a

a

a

a

e